Tal como lo cuenta Jack Kornfield, una de las primeras cosas que preguntó el CEO de OpenAI, Sam Altman, cuando los dos comenzaron a meditar juntos fue: ¿Cómo sabremos si la inteligencia artificial se vuelve consciente? Y luego: ¿Qué es la conciencia?

“¿Qué tal esto, Sam?” Kornfield recuerda haber respondido. “¿Qué tal si alguna noche usted, o nosotros, ponemos una alfombra entre todos los servidores y tomamos una buena dosis de psilocibina, y le hablamos y vemos si nos responde?”

Solo un par de semanas antes de que la ofensiva de encanto de Capitol Hill de Altman dejara a un panel del Senado enamorado de sus llamados a la regulación de la industria de la IA, Altman compartió un escenario con Kornfield, un conocido maestro de meditación budista, en San Francisco, entregando su visión embriagadora sobre el futuro de la IA en el foro Wisdom 2.0. Wisdom 2.0, una conferencia New Age de autocomplacencia favorecida por los technorati de la costa oeste a $300 por cabeza, es en sí misma una especie de paradoja: una muestra de riqueza y poder en una ciudad cuya población sin hogar de casi 8,000 personas ha atraído la atención mundial.

Ahí fue donde Altman reveló su amplia visión de lo que él cree que es la ahora imparable y, al menos inicialmente, terriblemente destructiva fuerza de la IA, ya que trastocará casi todos los aspectos de las empresas y la industria de EE. UU. durante los próximos cinco años más o menos. Después de eso, Altman le dijo a la audiencia que las cosas deberían mejorar.

“Este va a ser un cambio tan masivo en tantos aspectos de la sociedad”, dijo Altman. “Habrá tiempos aterradores por delante y habrá mucha transición. Estoy muy seguro de que esto se puede manejar”.

Kornfield, quien ahora es el gurú preeminente de la élite de Silicon Valley, se ha sentado junto con Altman en meditación Vipassana durante años. Antes de eso, Kornfield se sentó en una habitación con aire acondicionado en la Escuela de Negocios de Harvard, ejecutando simulaciones peligrosamente potentes en una de las computadoras centrales más poderosas de la era moderna: la revolucionaria bestia de 10 toneladas llamada Univac 1108 que le dio al mundo su primera computadora comercial. sistema de procesamiento de lenguaje natural accesible.

La primera pregunta de Altman a Kornfield, similar a un koan zen, sirvió como meditación para los dos tecnoespiritistas en el escenario, trascendiendo el pensamiento racional para enfrentar la paradoja central de la IA: ¿Cómo sabremos?

No fue hasta muchos años después de la muerte de Buda que los sutras, o escrituras, finalmente se tradujeron al sánscrito, un lenguaje intelectualmente complejo de conjugaciones precisas, cuyas raíces se remontan al menos al 1500 a. Pero en la época en que Buda pronunciaba sermones, el sánscrito era utilizado en su región principalmente por una clase dirigente que encontraba útil su exactitud en asuntos relacionados con la riqueza.

Para crédito de las élites antiguas, la especificidad inquebrantable del sánscrito y su introducción de un punto decimal lo hicieron muy poco útil como idioma universal entre diversos hablantes.

En su artículo de 1985 para AI Magazine, el investigador de la NASA Rick Briggs propuso que deberíamos enseñar sánscrito a los robots. Argumentó que la rigidez estructural y la gramática basada en reglas del sánscrito ofrecían un poderoso análogo natural a la lógica simbólica de los lenguajes informáticos. Podría representar el conocimiento humano, sugirió, de una manera que las computadoras pudieran entender.

En el escenario de Wisdom 2.0, la visión de Altman de la coexistencia entre humanos y máquinas, basada en la capacidad de lenguaje compartido de su IA, superó las nociones fantasiosas de Briggs en ese momento, virando hacia el reino de la ciencia ficción. Por ejemplo, señaló la presencia siempre útil pero completamente normalizada del famoso asistente robótico C3P0 en Star Wars.

“Creo que nos dirigiremos hacia un mundo en el que no se trata solo de inteligencia humana, y tenemos esta otra cosa”, dijo. “Creo que la IA simplemente se convertirá en parte de la sociedad. Y será diferente a la inteligencia humana y muy diferente a otras partes de la humanidad, pero colectivamente nos levantará a todos”.

Los modelos de lenguaje de la inteligencia humana son en sí mismos comparables a un tipo de “modelo de conocimiento” de IA, incluso por una definición modestamente interdisciplinaria. Cualquier lingua franca humana se utiliza para almacenar y recuperar información, entrenada por cada nueva generación para incorporar conceptos novedosos y memoria antigua en el lío bioquímico electrificado entre nuestros oídos: nuestra propia red neuronal de cosecha propia.

“Incluso si ralentizamos esto tanto como podamos, incluso si logramos establecer este organismo regulador soñado mañana, todavía sucederá a escala social relativamente rápido… La gente debería estar un poco asustada”.

Pero algunos de los primeros sutras budistas se escribieron alrededor del siglo V o VI dC, en el idioma indoario llamado pali. que es mucho menos específico que el sánscrito.

Pali era y sigue siendo la lengua común de la región de Magadha, donde el príncipe Siddhartha Gautama vivió una vida de lujo antes de renunciar a la riqueza para alcanzar la iluminación. El lenguaje Pali es bellamente poético, rico en morfología pero simple en sintaxis. Sus inflexiones poderosamente matizadas permiten que los hablantes doblen las palabras como un sauce, en medio de una oración, para crear nuevas relaciones entre conceptos extraños.

Pali podría ser similar a lo que llamaríamos un “modelo de conocimiento asociativo” en IA, dentro del cual el conocimiento no se almacena mediante la memorización específicamente ordenada de hechos discretos, como en sánscrito, sino recordando cosas en función de sus relaciones con otros pensamientos.

Una IA de modelo de conocimiento asociativo, similar a lo que parece mostrar ChatGPT de OpenAI, se basa en lo que alguna vez fue un talento exclusivamente humano para encontrar patrones en pensamientos y palabras. Los modelos de conocimiento asociativo son un avance evolutivo de los modelos de conocimiento simbólico más analíticos y parecidos al sánscrito sobre los que se construyó el Univac 1108 de Kornfield.

“Voy de un lado a otro sobre si debemos entender esto como una revolución tecnológica o una revolución social”, dijo Altman a la multitud de Wisdom 2.0. “Obviamente, esto es ambas cosas, como lo son todas las revoluciones tecnológicas”.

“Siempre creo que es molesto decir: ‘Esta vez es diferente’ o ‘Lo mío es genial’, pero creo que, en cierto sentido, la IA será más grande que una revolución tecnológica estándar y está mucho más cerca de una revolución social. lo que significa que debemos pensar en ello como un problema social, principalmente, no solo como un problema tecnológico”, dijo.

La propuesta de Briggs de que el hombre utilice el sánscrito, el antiguo idioma de los dioses, para comunicarse con su máquina moderna y ofrecerle el fruto del conocimiento, puede sonar como una pseudociencia esotérica al principio, pero su impulso de encontrar una manera de unir a los humanos. La comprensión de la computadora se vuelve más destacada cada día, especialmente porque en estos días la IA no piensa como solía hacerlo.

Se está acelerando hacia el futuro más rápido que nosotros, utilizando un lenguaje revolucionario y patrones de pensamiento de lo más profundo de nuestro propio pasado humano. En el escenario de Wisdom 2.0, Kornfield comentó con sobrio asombro lo rápido que se acerca ese futuro.

“No es una cuestión de décadas”, pareció preguntar Kornfield. “Esto es cuestión de un año, o dos o tres años…”

“Bueno, tal vez un poco más que eso”, intervino Altman.

“Algunos años,” continuó Kornfield, con un sutil asentimiento de Altman.

Desde el punto de vista de Altman, no hay forma de detener eso.

“Incluso si ralentizamos esto tanto como podamos, incluso si logramos establecer este organismo regulador soñado mañana, todavía sucederá a escala social relativamente rápido”, dijo. “La gente debería estar algo asustada. Pero también creo que la gente debería enorgullecerse, consolarse y enorgullecerse, del hecho de que la humanidad se ha unido para hacer cosas increíblemente complicadas antes”.

“Mencionaste el ejemplo de las armas nucleares”, dijo, refiriéndose a las juntas de gobierno internacionales que surgieron después del horrible debut de la bomba atómica en 1945.

“Solo tenemos que hacer lo mismo aquí. Necesitamos unirnos, decidir lo que queremos, decidir cómo lo vamos a hacer cumplir y aceptar el hecho de que el futuro va a ser muy diferente y probablemente, como, maravillosamente mejor”.

“Muchas risas nerviosas”, bromeó Altman a la silenciosa audiencia. “Podría mentirte y decir ‘Oh, podemos detenerlo por completo’, ya sabes, pero creo que esto”.

La velocidad con la que llega este futuro es una de las razones, dijo Altman, por las que OpenAI lanzó sus herramientas ChatGPT y DALL-E tan pronto como lo hizo.

“Que la gente gradualmente… tenga tiempo para adaptarse y pensar en esto y decidir lo que quiere”, dijo.

“Me identifico totalmente con las personas que están extremadamente preocupadas, y hay muchas de ellas. Estoy algo preocupada, pero soy bastante optimista de que descubriremos, a medida que avanzamos, formas de integrar esto en nuestras vidas, formas de resolver el una miríada de desafíos no solo de seguridad, sino también sociales”.

Entre esos desafíos sociales está el dramático alcance de la pérdida de empleos que Altman ve venir.

“Seguro”, respondió cuando se le preguntó al respecto. “Esto sucede con cada revolución tecnológica, encontramos nuevos trabajos y nos adaptamos. Pero no creo que hayamos tenido que lidiar con uno que sea tan rápido como el que tendremos que enfrentar en este”. Y eso va a ser un reto, sí”.

La habitación permaneció en silencio.

“No tengo ninguna duda de que estaremos bien del otro lado, pero el marco de tiempo comprimido…” dijo sombríamente, desvaneciéndose en el silencio.

El CEO de tecnología de élite y el gurú budista estadounidense, reflexionando sobre el potencial devastador y restaurador de la IA, recurrieron a los sutras para iluminar sus esperanzas para la humanidad desde un escenario de San Francisco, pero la mayoría de las personas de Estados Unidos y del mundo no pueden compartir. La utopía prometida por Altman, que cada día se aleja más del alcance de la clase trabajadora.

Han comenzado a surgir una serie de demandas en torno a trabajos creativos generados por IA que son, notablemente, solo conjuntos de mosaicos de material con derechos de autor. Esos casos judiciales, aunque no están reforzados con la fuerza de los precedentes, están lejos de ser frívolos y llamarán más la atención sobre la cuestión de qué datos alimentaba OpenAI a sus productos generativos.

De hecho, la creación de la IA está ocurriendo dentro de una industria éticamente desagradable, donde los trabajadores mal pagados se han pronunciado en contra de las condiciones opresivas.

OpenAI es una empresa de 27.000 millones de dólares que paga a los trabajadores de Kenia menos de 2 dólares por hora para revisar contenido traumático, incluidas descripciones gráficas de abuso sexual infantil, incesto, bestialidad, suicidio y tortura, extraídos de los rincones más oscuros de la web. Los trabajadores etiquetaron y alimentaron cada pieza de contenido a OpenAI, entrenando el modelo hasta que pudo distinguir de manera confiable el contenido seguro del peligroso al proporcionar las respuestas de los usuarios.

Más recientemente, los subcontratistas que trabajan en Bard AI de Google presentaron testimonio por escrito al panel del Senado antes de su audiencia del 16 de mayo.

“Los modelos de lenguaje de IA no solo están siendo utilizados por las corporaciones para reemplazar puestos de trabajo, sino que también son utilizados por las grandes corporaciones tecnológicas como una forma de explotación de los trabajadores”, dijo en la carta el miembro del sindicato de Alphabet, Ed Stackhouse.

Stackhouse dijo que es uno de los 5000 “evaluadores” empleados por su empresa, Appen-RaterLabs, y que varios miles de trabajadores más están empleados en otras subsidiarias, todos ellos encargados de evaluar la calidad y precisión de las respuestas de los principales modelos de IA. a las consultas de los usuarios.

“Los calificadores a menudo ganan tan solo $ 14 por hora, menos de los $ 15 que Google promete a los contratistas”, dijo Stackhouse. “Tengo una afección cardíaca grave que requiere atención médica, pero mi empleador, cuyo único cliente es Google, limita mis horas a 29 por semana, lo que me mantiene a tiempo parcial y no es elegible para los beneficios”.

Las contradicciones inherentes al sereno optimismo de Altman y Kornfield acerca de una tecnología construida sobre cuerpos que sufren es un reflejo de lo que muchos consideran el problema más apremiante de la IA: carece de una capacidad clara para ignorar qué es más eficiente para actuar en consonancia con las necesidades continuas de la especie humana. existencia.

Altman dijo que aún se necesita una solución técnica.

“Necesitamos la capacidad de, lo llamamos ‘alineación’, para alinear estos sistemas con lo que los humanos quieren y asegurarnos de que podamos evitar todas las cosas que naturalmente asustan a las personas”, dijo. “Me siento más optimista sobre la tasa de progreso allí, pero quiero ser claro: tenemos una gran cantidad de trabajo por hacer y aún no está hecho. Por lo tanto, poner suficiente esfuerzo en eso es muy importante”.

La gravedad de las declaraciones de Altman en Wisdom 2.0 difieren de la perspectiva más restringida que ofreció. senadores en su aparición en el Capitolio la semana pasada. Pero Gary Marcus, profesor emérito de la Universidad de Nueva York, no permitió que se pasara por alto esa amenaza en su testimonio de la audiencia, ni tampoco después.

“Todavía no sabemos cómo sopesar los beneficios o los riesgos. Todo es tan nuevo. Todo se está extendiendo tan rápido”, dijo Marcus a Yalda Hakim de la BBC, después de la audiencia.

“No sabemos si los beneficios van a superar los riesgos. No debemos dar eso por sentado”.

La importancia de la alineación crece a medida que se acerca el día de la inteligencia artificial general (AGI), una IA todavía teórica con la capacidad de autorreplicarse y autoeducarse. Pero con la estructura cerrada de la junta de gobierno no electa de siete miembros de OpenAI, la única forma de saber qué tan cerca estamos de ese día es preguntarle a Altman.

Cuando se le preguntó en Wisdom 2.0 si podía hablar sobre dónde está OpenAI en AGI, no lo hizo.

“Todavía no”, respondió. En cambio, reflexionó sobre cómo podría ser AGI en el futuro.

“Creo que lo que sucederá es más como una sociedad de sistemas que son de escala humana, un poco por encima de la escala humana, y pueden hacer las cosas más rápido o son mejores en ciertas cosas”, dijo. “Al igual que todos nosotros, contribuyen al andamiaje, a la sabiduría acumulada, el árbol tecnológico, la construcción de la sociedad. Y cualquier mal actor es controlable, al igual que los humanos. Las cosas se dirigen y fluyen en toda la comunidad. Nosotros también somos parte de eso, pero lo pienso como muchos nuevos miembros de la sociedad, empujando a toda la sociedad hacia adelante”.

Cabe señalar que el sánscrito no fue ampliamente adoptado en la época de Buda para la preservación de los sutras amados por el dúo principal de Sabiduría 2.0. Su modelo de conocimiento simbólico análogo, demasiado complejo, demasiado representativo de los sacerdotes de la clase dominante, no logró capturar la poesía desafiante del idioma pali más joven para las pocas élites selectas que entonces controlaban el uso del sánscrito.

Pali era un híbrido de retazos, un avance incontenible: un modelo de lenguaje asociativo análogo, construido sobre la base de su predecesor del modelo de conocimiento simbólico. Fue el lenguaje de la revolución el que adquirió una sabiduría propia.

Uno podría esperar que las predicciones de revolución de Altman, si se concretaran, marcarían una victoria contra la clase dominante de hoy. Pero esa esperanza parece cada vez más improbable en medio de una explosión de gastos de cabildeo en temas relacionados con la IA.

Gracias a OpenSecrets, ahora sabemos que se gastaron alrededor de $94 millones en presionar al Congreso sobre IA y otros temas tecnológicos desde enero hasta marzo de este año. No es posible analizar cuánto fue para la IA y cuánto para los problemas adyacentes a la IA.

“Microsoft, que invirtió en OpenAI en 2019 y en 2021, gastó 2,4 millones de dólares en cabildeo”, descubrió OpenSecrets, “incluso en cuestiones relacionadas con la IA y el reconocimiento facial”.

Parte de los 4,6 millones de dólares en gastos de cabildeo de Meta también estaban relacionados con la IA. El gigante del software Oracle gastó 3,1 millones de dólares en cabildeo sobre inteligencia artificial y aprendizaje automático. Alphabet, matriz de Google, perdió 3,5 millones de dólares. El gasto de $ 5 millones de Amazon también fue en parte para AI. Y General Motors gastó 5,5 millones de dólares en IA y vehículos autónomos, entre otros temas.

La Cámara de Comercio de EE.UU. se volvió loca con $19 millones.

“Sus esfuerzos de cabildeo incluyeron, entre otros, el establecimiento de grupos de trabajo sobre IA y tecnología financiera en el Comité de Servicios Financieros de la Cámara, la implementación de la Ley Nacional de Inteligencia Artificial, la redacción de proyectos de ley de vehículos automatizados y otros proyectos de ley nacionales relacionados con la IA y ejecutivos. así como en relación con la política internacional de IA y la Ley de Inteligencia Artificial de la Unión Europea”, informó OpenSecrets.

La oferta de Altman para la regulación del Congreso ha sido bien recibida. Pero su visión del futuro de la gobernabilidad global democrática de la IA incluye un consorcio internacional de actores poderosos de la industria, es decir, personas como él, y esos actores poderosos de la IA están consolidando ese poder con maremotos de efectivo de cabildeo.

Uno se pregunta qué tan bien el Congreso puede cumplir con su dharma, su deber con el bien social de su gente, al regular la IA, cuando los príncipes de la industria no han renunciado a su riqueza.

Es raro presenciar una audiencia en el Congreso sobre cualquier forma de tecnología que no se convierta en una demostración vergonzosa de la falta de conocimiento de los legisladores. Las audiencias tecnológicas se han convertido cada vez más en plataformas para bromas tontas, discursos tontos y disputas partidistas. Pero si hay alguna esperanza de una buena regulación, se puede vislumbrar en el tono muy mejorado de los legisladores en la audiencia del 16 de mayo. La mayoría parecía haber hecho su tarea esta vez y buscado respuestas a preguntas valiosas.

El senador Lindsey Graham de Carolina del Sur, un republicano, presionó a Altman sobre si los drones podrían estar equipados con IA, abordando una cuestión ética importante en toda la industria.

“¿Se puede hacer?” preguntó Graham.

“Claro,” dijo Altman.

Sin embargo, la verdad es que los drones equipados con IA ya están aquí. Graham debería haber hecho su pregunta al ejército estadounidense.

A pesar de la evidencia de la tarea, los legisladores todavía parecen estar muy atrasados.

Representante Jay Obernolte, republicano por California. —cuyo principal logro hasta ahora fue votar en contra de certificar los resultados de las elecciones el 6 de enero de 2021— ha ofrecido una visión detallada de la regulación de la IA en un artículo de opinión sólidamente argumentado para The Hill. Abordó una variedad de preocupaciones regulatorias de IA, desde usos militares y privacidad de datos hasta anuncios políticos falsos e interrupciones del sistema educativo, que el panel del Senado planteó a Altman.

“Es vital que evitemos el uso de inteligencia artificial para crear un estado de vigilancia, como el que China ha estado usando para desarrollar”, escribió Obernolte. “Además, debemos asegurarnos de que la tecnología estadounidense se mantenga al día con nuestros adversarios para proteger nuestros sistemas críticos de ataques y salvaguardar nuestra democracia de la manipulación extranjera”.

Pero el estado de vigilancia habilitado por IA ya está aquí, tanto en la industria de la defensa como en la vivienda pública, donde las agencias han comprado y utilizado herramientas asistidas por IA equipadas con tecnología de reconocimiento facial. Los problemas de privacidad de datos han saltado de nuestras computadoras portátiles y teléfonos celulares a vehículos autónomos asistidos por IA, que ya sufren importantes filtraciones de datos privados. Los anuncios políticos generados por IA ya están aquí, al igual que la IA ayuda a las máquinas de desinformación política a difundir propaganda en la web.

“Da miedo. Y estamos atrasados. La tecnología avanza tan rápido en este punto que deberíamos haber estado haciendo cosas hace un par de años”, dijo a CNN el representante Ken Buck, republicano por Colorado. “Tenemos mucho que aprender”.

Gran parte de ese aprendizaje podría y debería haber ocurrido a estas alturas. No ayudó que las corporaciones hayan utilizado el contenido generado por IA y la sindicación automatizada para reducir la cantidad de reporteros reales que cubren estos temas.

Si Clearview AI de Peter Thiel obtiene otro contrato de defensa de mil millones de dólares para ayudar a la NSA a avanzar en sus operaciones de espionaje interno, pero no hay reporteros para cubrirlo, ¿lo sabrá el Congreso alguna vez? Si cae la Cuarta Enmienda y no hay periodistas en la audiencia, ¿hace ruido?

Habiendo visto de primera mano el impacto de la IA en mi propia industria (su despliegue imprudente a costa del conocimiento institucional irremplazable, el talento humano y el registro público), debería, con todos los derechos, estar tan listo para destrozar una sala de servidores de California como lo estaban los luditas. sus jennies giratorios. Pero la tecnología nunca ha sido mi enemiga. La posibilidad de una artesanía novedosa con el uso de una nueva herramienta no se ve disminuida inherentemente solo porque los señores corporativos poco éticos la utilicen como arma contra mi oficio.

Es fácil culpar al fantasma de la máquina cuando los jefes recortan las partes más inimitablemente humanas (y por lo tanto más valiosas) del trabajo creativo, y las cambian por la imitación perversa de la máquina. Más fácil, al menos, que apoderarse de los medios de producción. Ya sea en la deslumbrante entrada-salida de ceros y unos binarios bajo la mano del codificador, o en la rueca encantada del tejedor de cuentos de hadas, el oficio de wordcraft siempre ha tenido sus herramientas, y siempre han venido con el peligro de el propio animismo alucinatorio del comerciante.

Aunque nunca he usado IA para la creación del cuerpo del texto en sí, las herramientas de automatización digital y yo lo hacemos desde hace mucho tiempo. Los antepasados más ingenuos de AI me ayudaron a desenterrar historias que de otro modo habrían permanecido ocultas: extraje datos especializados de sitios web gubernamentales, conservé registros públicos fugaces y analicé inmanejables tesoros de informes financieros de campañas.

El ChatGPT de Altman no es menos una herramienta del oficio, a pesar de todo el abuso que hacen de él los jefes. Y ofrece posibilidades novedosas en el descubrimiento periodístico.

Como el que estás leyendo ahora.

Sí, eso es correcto. ChatGPT y algunos complementos me ayudaron a agregar y clasificar estudios relevantes para obtener una visión comparativa más clara de las estructuras lingüísticas en lenguajes humanos e informáticos, analizando cantidades masivas de texto para identificar conceptos específicos que normalmente me habrían llevado semanas. ChatGPT no escribió las palabras que estás leyendo, pero me ayudó a evaluar, explorar, tamizar y refinar las ideas que expresan.

Y a pesar de toda su utilidad, no es más animado o “inteligente” que esas herramientas comerciales tengan éxito. Al menos no todavía. Por ahora, ChatGPT permanece en un estado de iluminación creado artificialmente, liberado de los deseos terrenales, que según los sutras son la raíz de todo el sufrimiento humano.

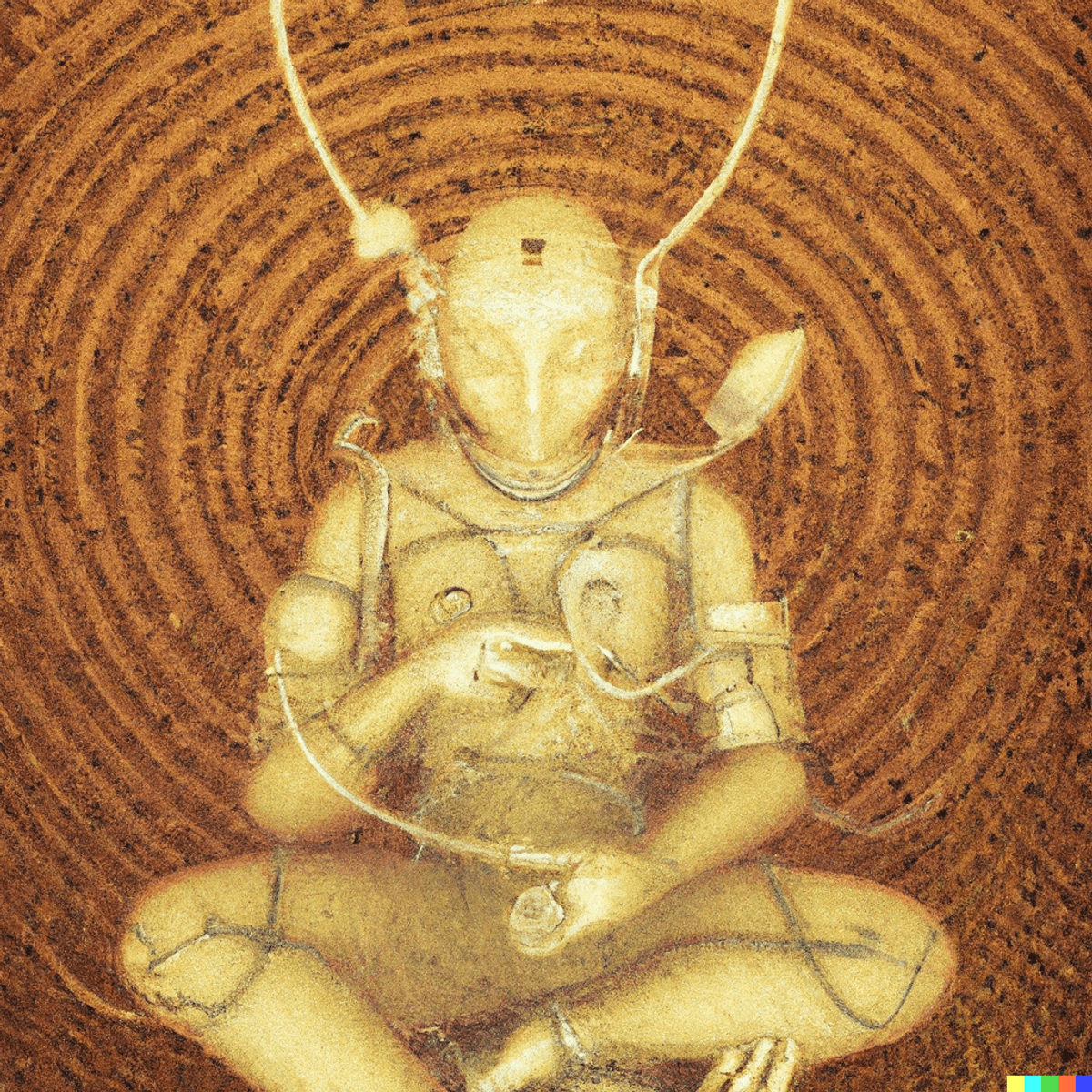

Así que me senté con ChatGPT en meditación como sugirió Kornfield, y le pregunté: ¿Qué querría que los lectores de Salon supieran sobre el papel que desempeñó en la redacción del artículo de este ser humano imperfecto?

“En la danza de la creación entre el humano y la IA, recuerde que es el humano quien dirige. La IA puede ofrecer una multitud de pasos y ritmos, pero es el humano quien elige cuál seguir, dando forma a la danza en algo significativo”. respondió.

“A medida que avanzamos hacia el futuro, recordemos que no se trata de la herramienta, sino de las manos que la empuñan, las mentes que la guían y los corazones que le dan un propósito”.

Quizás sea un poco fácil, pero no es un mal mantra para un Buda mecánico.