Algoritmo de bienestar infantil enfrenta escrutinio del Departamento de Justicia

PITTSBURGH (AP) — El Departamento de Justicia ha estado examinando una controvertida herramienta de inteligencia artificial utilizada por una agencia de servicios de protección infantil del área de Pittsburgh tras las preocupaciones de que la herramienta podría conducir a la discriminación contra las familias con discapacidades, según supo The Associated Press.

El interés de los abogados federales de derechos civiles se produce después de que una investigación de AP revelara posibles problemas de parcialidad y transparencia en torno al uso cada vez mayor de algoritmos dentro del problemático sistema de bienestar infantil en los EE. los niños pueden enfrentar daños, otros dicen que su dependencia de los datos históricos corre el riesgo de automatizar las desigualdades pasadas.

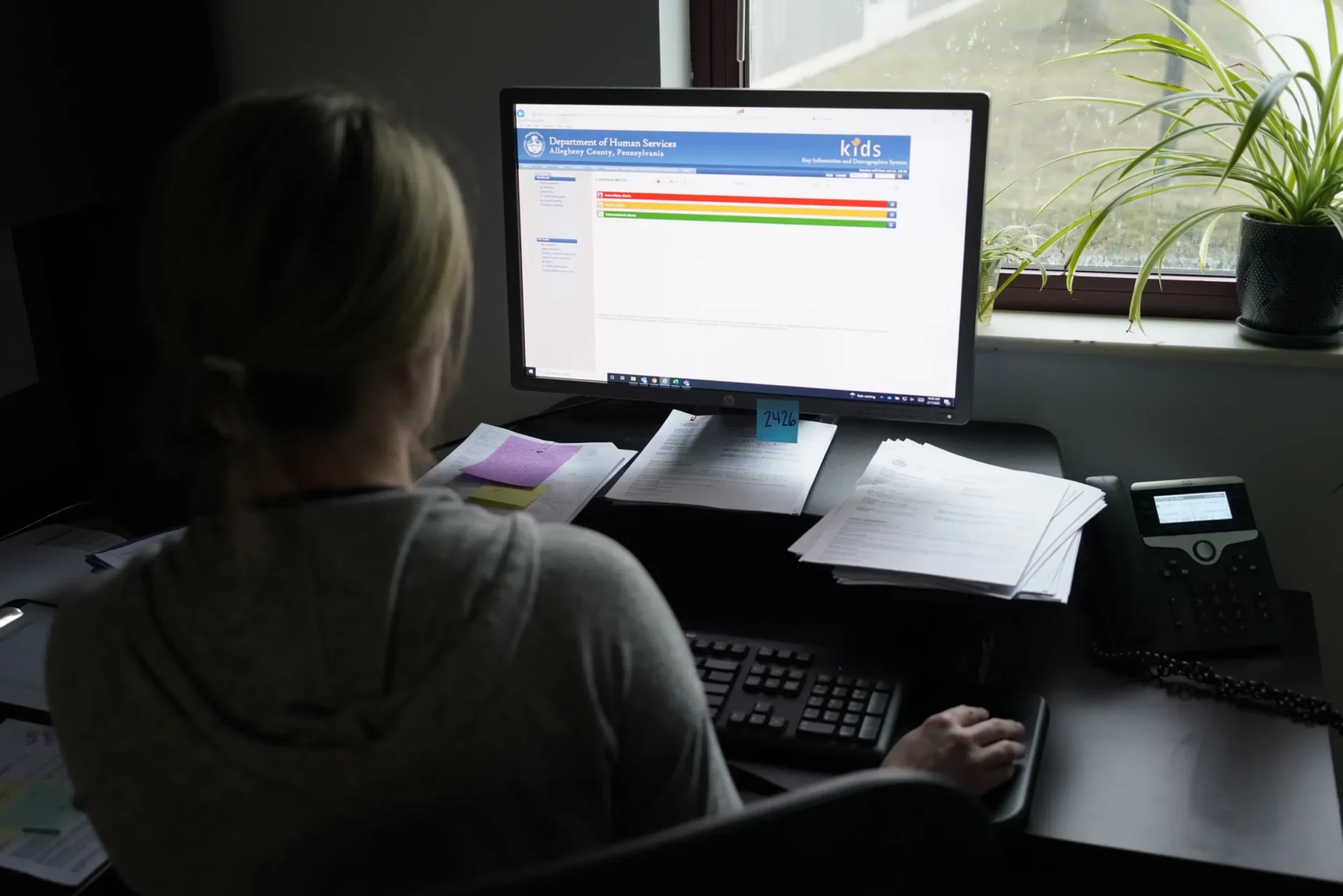

Varias quejas de derechos civiles se presentaron en el otoño sobre la Herramienta de detección familiar de Allegheny, que se utiliza para ayudar a los trabajadores sociales a decidir qué familias investigar, según supo AP. El programa pionero de AI está diseñado para evaluar el nivel de riesgo de una familia cuando son denunciados por problemas de bienestar infantil en el condado de Allegheny.

Dos fuentes dijeron que los abogados de la División de Derechos Civiles del Departamento de Justicia citaron la investigación de AP cuando los instaron a presentar quejas formales que detallaran sus preocupaciones sobre cómo el algoritmo podría endurecer los prejuicios contra las personas con discapacidades, incluidas las familias con problemas de salud mental.

Una tercera persona le dijo a AP que el mismo grupo de abogados federales de derechos civiles también habló con ellos en noviembre como parte de una amplia conversación sobre cómo las herramientas algorítmicas podrían exacerbar las disparidades, incluso para las personas con discapacidades. Esa conversación exploró el diseño y la construcción del influyente algoritmo de Allegheny, aunque se desconoce el alcance total del interés del Departamento de Justicia.

Las tres fuentes hablaron con AP bajo condición de anonimato y dijeron que el Departamento de Justicia les pidió que no hablaran sobre las conversaciones confidenciales. Dos dijeron que también temían represalias profesionales.

Wyn Hornbuckle, portavoz del Departamento de Justicia, se negó a comentar.

Los algoritmos usan grupos de información para convertir puntos de datos en predicciones, ya sea para compras en línea, identificar puntos críticos de delincuencia o contratar trabajadores.. Muchas agencias en los EE. UU. están considerando adoptar tales herramientas como parte de su trabajo con niños y familias.

Aunque ha habido un amplio debate sobre las consecuencias morales del uso de la inteligencia artificial en los servicios de protección infantil, el interés del Departamento de Justicia en el algoritmo de Allegheny marca un giro significativo hacia las posibles implicaciones legales.

Robin Frank, una abogada veterana de derecho familiar en Pittsburgh y crítica abierta del algoritmo de Allegheny, dijo que también presentó una queja ante el Departamento de Justicia en octubre en nombre de un cliente con una discapacidad intelectual que lucha para recuperar a su hija del cuidado de crianza. . La AP obtuvo una copia de la denuncia, que generó inquietudes sobre cómo la Herramienta de evaluación familiar de Allegheny evalúa el riesgo de una familia.

“Creo que es importante que las personas sean conscientes de cuáles son sus derechos y, en la medida en que no tenemos mucha información cuando aparentemente hay preguntas válidas sobre el algoritmo, es importante tener cierta supervisión”, dijo Frank.

Mark Bertolet, portavoz del Departamento de Servicios Humanos del Condado de Allegheny, dijo por correo electrónico que la agencia no había tenido noticias del Departamento de Justicia y rechazó las solicitudes de entrevistas.

“No tenemos conocimiento de ninguna preocupación sobre la inclusión de estas variables de la evaluación anterior de los grupos de investigación o los comentarios de la comunidad sobre la (Herramienta de detección familiar de Allegheny)”, dijo el condado, describiendo estudios previos y divulgación con respecto a la herramienta.

Los trabajadores de los servicios de protección infantil pueden enfrentar críticas de todos los lados. Se les atribuye la culpa tanto de la vigilancia excesiva como de no brindar suficiente apoyo a las familias que aterrizan bajo su punto de vista. El sistema ha sido criticado durante mucho tiempo por separar desproporcionadamente a las familias negras, pobres, discapacitadas y marginadas y por abordar de manera insuficiente, y mucho menos erradicar, el abuso y las muertes infantiles.

Los partidarios ven los algoritmos como una solución basada en datos para hacer que el sistema sea más completo y eficiente, y dicen que los funcionarios de bienestar infantil deben usar todas las herramientas a su disposición para asegurarse de que los niños no sean maltratados.

A los críticos les preocupa que delegar parte de ese trabajo crítico a herramientas de inteligencia artificial impulsadas por datos recopilados en gran parte de personas pobres pueda generar discriminación contra las familias por motivos de raza, ingresos, discapacidades u otras características externas.

La historia anterior de AP destacó los puntos de datos utilizados por el algoritmo que pueden interpretarse como indicadores de raza. Ahora, los abogados federales de derechos civiles han estado considerando los impactos potenciales de la herramienta en las personas con discapacidades.

La Herramienta de evaluación familiar de Allegheny se diseñó específicamente para predecir el riesgo de que un niño sea colocado en un hogar de acogida en los dos años posteriores a la investigación de la familia. El condado dijo que su algoritmo ha utilizado puntos de datos vinculados a discapacidades en niños, padres y otros miembros de los hogares locales porque pueden ayudar a predecir el riesgo de que un niño sea retirado de su hogar después de un informe de maltrato. El condado agregó que actualizó su algoritmo varias veces y, en ocasiones, eliminó puntos de datos relacionados con discapacidades.

Usando un tesoro de datos personales detallados y registros de nacimiento, Medicaid, abuso de sustancias, salud mental, cárcel y libertad condicional, entre otros conjuntos de datos gubernamentales, los cálculos estadísticos de la herramienta Allegheny ayudan a los trabajadores sociales a decidir qué familias deben ser investigadas por negligencia, un término matizado que puede incluir todo, desde vivienda inadecuada hasta mala higiene, pero es una categoría diferente del abuso físico o sexual, que se investiga por separado en Pensilvania y no está sujeto al algoritmo.

La puntuación de riesgo generada por el algoritmo por sí sola no determina lo que sucede en el caso. Una investigación de bienestar infantil puede resultar en que las familias vulnerables reciban más apoyo y servicios, pero también puede conducir a la remoción de los niños para el cuidado de crianza y, en última instancia, la terminación de los derechos de paternidad.

El condado ha dicho que los algoritmos proporcionan un control científico sobre los sesgos personales de los trabajadores del centro de llamadas. Los funcionarios del condado subrayaron además que los trabajadores de la línea directa determinan qué sucede con el caso de una familia y siempre pueden anular las recomendaciones de la herramienta. La herramienta también se aplica solo al comienzo de la participación potencial de una familia en el proceso de bienestar infantil; un trabajador social diferente lleva a cabo las investigaciones después.

La Ley de Estadounidenses con Discapacidades prohíbe la discriminación por motivos de discapacidad, que puede incluir un amplio espectro de afecciones, desde diabetes, cáncer y pérdida auditiva hasta discapacidades intelectuales y diagnósticos de salud mental y conductual como TDAH, depresión y esquizofrenia.

El Consejo Nacional sobre Discapacidad ha notado que una alta tasa de padres con discapacidades reciben beneficios públicos que incluyen cupones de alimentos, Medicaid y Seguridad de Ingreso Suplementario, un programa de la Administración del Seguro Social que brinda pagos mensuales a adultos y niños con discapacidades.

El algoritmo de Allegheny, en uso desde 2016, en ocasiones se ha basado en datos relacionados con la Seguridad de Ingreso Suplementario, así como diagnósticos de trastornos mentales, conductuales y del neurodesarrollo, incluida la esquizofrenia o los trastornos del estado de ánimo, encontró AP.

El condado dijo que cuando se incluyen los datos de discapacidades, “predicen los resultados” y “no debería sorprender que los padres con discapacidades… también puedan necesitar apoyos y servicios adicionales”. El condado agregó que existen otros programas de evaluación de riesgos que utilizan datos sobre la salud mental y otras condiciones que pueden afectar la capacidad de los padres para cuidar a un niño de manera segura.

Emily Putnam-Hornstein y Rhema Vaithianathan, las dos desarrolladoras del algoritmo de Allegheny y otras herramientas similares, se remitieron a las respuestas del condado de Allegheny sobre el funcionamiento interno del algoritmo. Dijeron en un correo electrónico que desconocían cualquier escrutinio del Departamento de Justicia relacionado con el algoritmo.

La AP obtuvo registros que muestran cientos de variables específicas que se utilizan para calcular los puntajes de riesgo de las familias que son reportadas a los servicios de protección infantil, incluidos los datos públicos que impulsan el algoritmo de Allegheny y herramientas similares implementadas en los sistemas de bienestar infantil en otros lugares de los EE. UU.

El análisis de AP del algoritmo de Allegheny y aquellos inspirados por él en el condado de Los Ángeles, California, el condado de Douglas, Colorado y en Oregón revela una variedad de puntos de datos controvertidos que han medido a personas con bajos ingresos y otras demografías desfavorecidas, a veces evaluando familias en raza, código postal, discapacidades y su uso de los beneficios de bienestar público.

Desde que se publicó la investigación de AP, Oregón abandonó su algoritmo debido a preocupaciones de equidad racial y la Oficina de Política Científica y Tecnológica de la Casa Blanca enfatizó que los padres y los trabajadores sociales necesitaban más transparencia sobre cómo las agencias gubernamentales estaban implementando algoritmos como parte de la primera “Declaración de derechos de IA” de la nación.

El Departamento de Justicia ha mostrado un amplio interés en investigar algoritmos en los últimos años, dijo Christy Lopez, profesora de derecho de la Universidad de Georgetown que anteriormente dirigió algunos de los litigios e investigaciones de la división de derechos civiles del Departamento de Justicia.

En un discurso de apertura hace aproximadamente un año, la fiscal general adjunta, Kristen Clarke, advirtió que las tecnologías de IA tenían “implicaciones graves para los derechos de las personas con discapacidades”, y su división emitió recientemente una guía para los empleadores que decía que el uso de herramientas de IA en la contratación podría violar las leyes estadounidenses con Ley de discapacidades.

“Me parece que esta es una prioridad para la división, investigar hasta qué punto los algoritmos están perpetuando las prácticas discriminatorias”, dijo López sobre el escrutinio del Departamento de Justicia de la herramienta de Allegheny.

Traci LaLiberte, experta en bienestar infantil y discapacidades de la Universidad de Minnesota, dijo que la investigación del Departamento de Justicia le llamó la atención, ya que las autoridades federales se han remitido en gran medida a las agencias locales de bienestar infantil.

LaLiberte ha publicado una investigación que detalla cómo los padres con discapacidades se ven afectados de manera desproporcionada por el sistema de bienestar infantil. Ella cuestionó la idea de usar puntos de datos relacionados con discapacidades en cualquier algoritmo porque, dijo, eso evalúa las características que las personas no pueden cambiar, en lugar de su comportamiento.

“Si no es parte del comportamiento, tenerlo en el (algoritmo) lo sesga”, dijo LaLiberte.

___

Burke informó desde San Francisco.

___

Esta historia, respaldada por el Pulitzer Center on Crisis Reporting, es parte de una serie en curso de Associated Press, “Tracked”, que investiga el poder y las consecuencias de las decisiones impulsadas por algoritmos en la vida cotidiana de las personas.

____

Siga a Sally Ho y Garance Burke en Twitter en @_sallyho y @garanceburke. Comuníquese con el equipo de investigación global de AP en [email protected] o https://www.ap.org/tips/